欢迎光临我的博客

我将会在此分享我的学习笔记,资料,以及一些生活中的点滴。

谢谢每一位朋友的友好访问!

论文:ILVR: Conditioning Method for Denoising Diffusion Probabilistic Models

论文:More Control for Free! Image Synthesis with Semantic Diffusion Guidance

论文:Classifier-Free Diffusion Guidance Jonathan Ho & Tim Salimans

论文:Diffusion Models Beat GANs on Image Synthesis Prafulla Dhariwal Alex Nichol

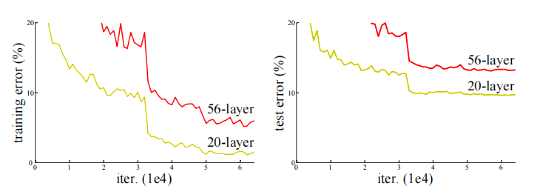

网络退化:层次变深后性能还不如之前的网络(并不是梯度消失或梯度爆炸,也不是过拟合)

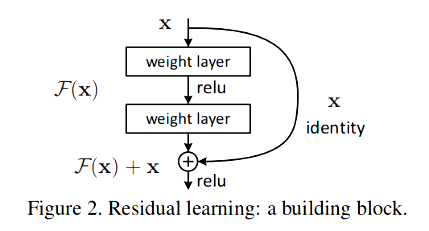

右侧的支路也被称为短路连接(shortcut connection)。引入短路连接,既没有引入额外的参数,也没有增加计算复杂度。

求和之后再用ReLU激活函数。注意输入和输出必须为同维(逐个元素相加)。

过去是直接拟合\(H(x)\),现在是拟合残差\(F(x)=H(x)-x\)

残差块的结构:

残差网络的优点:①易于优化收敛。②解决网络退化问题。③可以使网络变得很深,准确率大大提升。

resnet_main.py

深度学习处理的数据一般是[0,1],而图片数据的取值范围是[0,255],所以一般导入图片数据的时候做一次预处理/255。

彩色图片有3个通道,每个通道上都是以[0,255]的数值进行图片对应通道上的存储。

全连接神经网络参数众多,难以训练,而且容易过拟合,因因此引入了卷积神经网络。

特征图上的每个数值都是通过上一层的输入通过卷积核计算得到的。

将卷积层进行层层堆叠,就形成了深度卷积网络。在目前的硬件条件下,可以实现几百上千层的卷积层结构。卷积层越多,对复杂结构的特征识别能力越强。

激活函数一般是ReLU(把小于零的值剔除)。

池化层可以放大主要特征,忽略掉几个像素的偏差,抓住主要矛盾,忽略次要矛盾。可以减少数据维度,减少训练参数,避免过拟合。

批归一化的好处:①收敛速度更快(避免的了梯度离散现象,能更好的的更新参数)②更容易得到更好的解 ③训练更稳定

Lenet5_main.py